-

Le opinioni espresse nel presente documento non costituiscono ricerca, consulenza di investimento o raccomandazioni di acquisto o di vendita, e non rappresentano necessariamente le opinioni di tutti i team di gestione di AB; tali opinioni sono soggette a revisione nel corso del tempo.

Etica e regolamentazione dell'IA: orientarsi nel labirinto

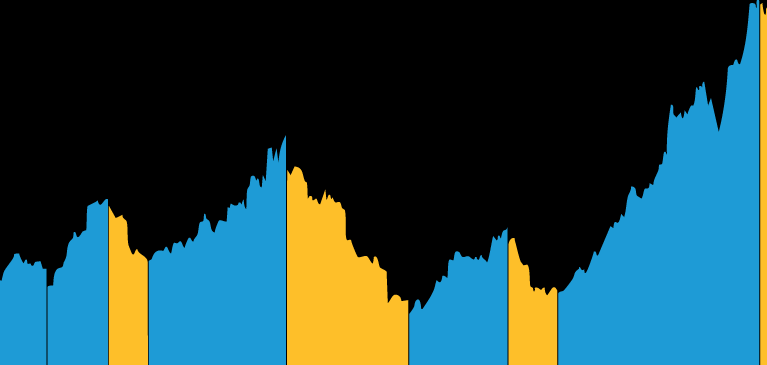

Solo per scopi illustrativi.

Al 31 dicembre 2022

Fonte: AI, Algorithmic and Automation Incidents and Controversies (AIAAIC) Repository; e Nestor Maslej, Loredana Fattorini, Erik Brynjolfsson,

John Etchemendy, Katrina Ligett, Terah Lyons, James Manyika, Helen Ngo, Juan Carlos Niebles, Vanessa Parli, Yoav Shoham, Russell Wald, Jack Clark e Raymond Perrault, The AI Index 2023 Annual Report, AI Index Steering Committee, Institute for Human-Centered AI, Stanford University, Stanford, CA, aprile 2023.

Solo per scopi illustrativi.

Fonte: AllianceBernstein (AB)

-

Integrazione dell'IA: In che modo è stata integrata l'IA nella strategie aziendale complessiva dell'impresa? Quali sono alcuni esempi specifici di applicazioni dell'IA all'interno dell'azienda?

-

Supervisione e competenze del CdA: In che modo il CdA si assicura di avere competenze sufficienti per supervisionare efficacemente la strategia e l'implementazione dell'IA nell'azienda? Sono previsti programmi o iniziative di formazione specifici?

-

Impegno pubblico per un'IA responsabile: L'azienda ha pubblicato una politica o un quadro di riferimento formale sull'IA responsabile? In che misura questa politica è allineata agli standard di settore, alle considerazioni etiche sull'IA e alla normativa in materia?

-

Trasparenza proattiva: L'azienda ha adottato proattivamente misure di trasparenza per far fronte a future implicazioni normative?

-

Gestione del rischio e responsabilità: Quali processi di gestione del rischio ha adottato l'azienda per identificare e mitigare i rischi legati all'IA? La responsabilità della supervisione di questi rischi è stata delegata?

-

Problemi inerenti ai dati negli LLM: In che modo l'azienda affronta i problemi di privacy e copyright associati ai dati utilizzati per addestrare i modelli linguistici di grandi dimensioni? Quali misure sono state prese per assicurare che i dati usati come input siano conformi alle norme sulla privacy e alle leggi sul copyright, e in che modo l'azienda gestisce le restrizioni o i requisiti relativi ai dati?

-

Problemi di distorsioni ed equità nei sistemi di IA generativa: Quali sono le misure adottate dall'azienda per prevenire e/o mitigare risultati distorti o iniqui nei suoi sistemi di IA? Cosa fa l'azienda per garantire che i risultati dei sistemi di IA generativa utilizzati siano equi e imparziali e che non perpetuino discriminazioni o danni nei confronti di alcun individuo o gruppo?

-

Tracciamento e segnalazione degli incidenti: Quali procedure segue l'azienda per tracciare e segnalare gli incidenti relativi allo sviluppo o all'utilizzo dell'IA, e quali meccanismi sono in atto per affrontare questi incidenti e farne tesoro?

-

Metriche e reporting: Quali sono le metriche utilizzate dall'azienda per misurare le prestazioni e l'impatto dei suoi sistemi di IA, e come vengono comunicate agli stakeholder esterni? Cosa fa l'azienda per mantenere la dovuta diligenza nel monitoraggio della conformità normativa delle sue applicazioni di IA?